type

Post

status

Published

date

Oct 2, 2025

slug

dlai1

summary

大型语言模型是通往AGI的一条死路。

tags

思考

推荐

文字

category

心情随笔

icon

password

Description

在人工智能(AI)领域,大型语言模型(LLM)无疑是当下最炙手可热的明星。从ChatGPT的惊艳亮相到各类模型的竞相涌现,LLM的成功和围绕它的巨大声浪几乎让我们相信,这就是通往通用人工智能(AGI)的康庄大道。

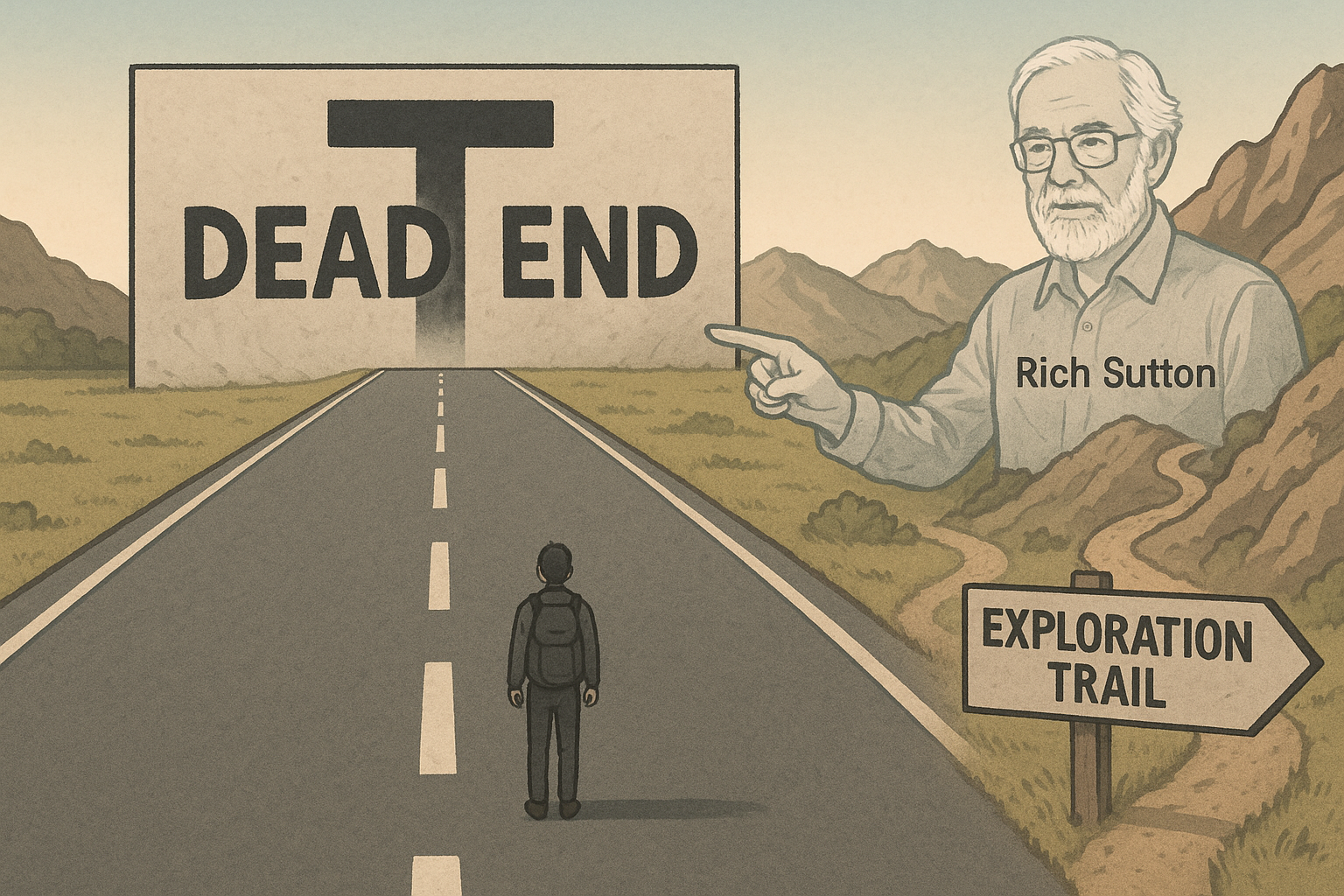

然而,就在此时,一位行业泰斗级人物却提出了振聋发聩的反对之声。他就是被誉为“强化学习之父”、图灵奖得主Rich Sutton。在他最近的一次访谈中,他直言不讳地指出,大型语言模型是“一条死路”。

这并非哗众取宠的言论,而是来自一位顶尖科学家对智能本质的深刻反思。接下来我们来深入解读Sutton访谈中5个最具颠覆性的观点,它们将为你提供一个与主流叙事截然不同的视角,重新审视通往AGI的真正路径。

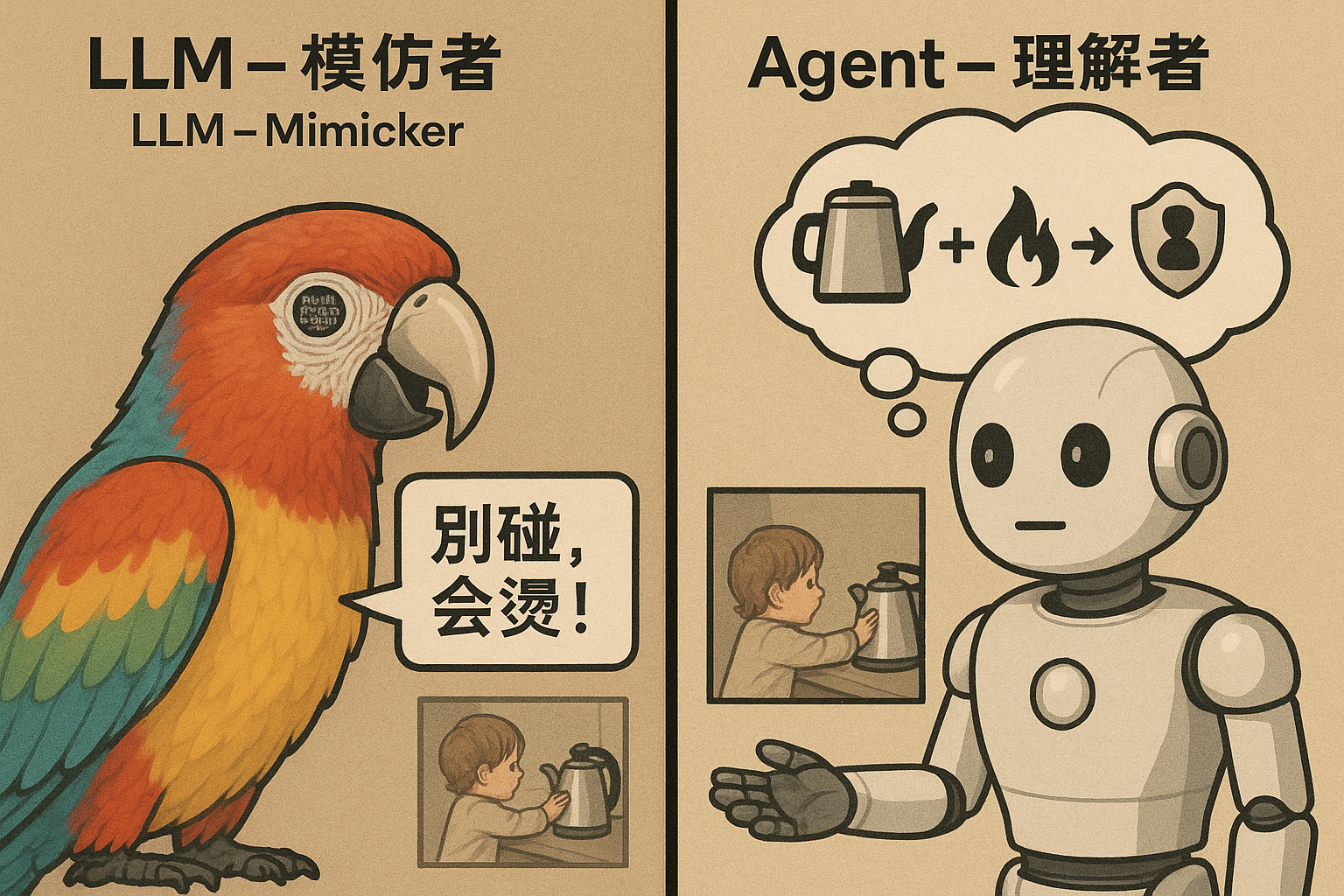

1. 核心缺陷:大型语言模型缺乏“目标”,只是“模仿者”

Sutton开门见山地指出了LLM的根本问题。对他来说,拥有目标是智能的本质。真正的智能是关于理解世界并通过行动实现目标,而LLM却被困在了模仿人类语言的阶段,未能触及理解的内核。LLM缺乏一个根本性的目标导向,这导致了三个致命缺陷。

- 缺乏真实的世界模型 (Lack of a True World Model): Sutton强调,预测人类会说什么,和预测世界会发生什么是完全不同的两件事。前者是模仿,后者才是理解。例如,看到一个孩子要触摸热水壶,一个拥有世界模型的智能体会立刻预测到“触摸会导致烫伤”这个物理后果,并为了“保护孩子”这个目标采取行动阻止。而LLM只能根据训练数据预测,人类在这种场景下最可能会说“别碰,会烫!”。它本身并不理解热水壶、烫伤这些概念背后的物理意义和因果关系,因为它没有理解世界以达成目标的需求,只有模仿文本的浅层任务。

- 没有“地面实况” (No Ground Truth): 在很多真实场景中,反馈是明确的。例如,在训练AI玩《打砖块》游戏时,得分和失分就是清晰的“地面实况”(Ground Truth),系统可以据此判断自己的行为是否正确。但LLM生成文本时却没有这样的标准。你让它写一篇关于“如何提升专注力”的文章,你无法给出一个绝对“正确”或“错误”的评分。既然没有对错的判断标准,系统就无法真正地学习和改进。

- 无法从经验中学习 (Inability to Learn from Experience): 人类的学习本质上是通过预期与现实的偏差来调整认知的。但LLM不具备这种能力,它们“不会对接下来发生的事情感到惊讶”。例如,你问LLM把冰块放进微波炉会怎样,它会根据数据回答“冰块会融化”。但如果你实际操作时,因为功率太低,冰块半小时都没融化,LLM并不会因为这个“意外”而更新自己的知识。它无法从直接的、一手经验中修正自己的判断。

当被问及“预测下一个词”算不算一个目标时,Sutton的回答一针见血:“那不是目标……你并不会影响它们。” 换言之,LLM的预测任务是被动的,它不会为了更好地预测而主动改变世界或探索世界,这与一个为了达成目标而主动与世界交互的智能体有着本质区别。

强化学习是关于理解你的世界,而大语言模型是关于模仿人类做人们说你应该做的事情。他们不是在搞清楚该做什么。

2. 重新解读:我们都误会了“苦涩的教训”

许多人引用Sutton在2019年发表的著名文章《苦涩的教训》(The Bitter Lesson)来为LLM以规模取胜的路线辩护。他们认为,LLM利用海量计算处理海量数据,正符合文章的核心思想。然而,Sutton在访谈中明确表示,这是一种误读。

他澄清道,《苦涩的教训》的真正含义是:那些依赖纯粹计算能力的通用方法,最终总会胜过那些严重依赖人类知识的方法。

LLM虽然计算规模巨大,但其根基——互联网上的海量文本——本身就是人类知识的集合。因此,LLM恰恰违反了“苦涩的教训”中“不依赖人类知识”的核心原则。Sutton用国际象棋AI举例:早期的象棋程序依赖人类总结的开局和策略,但后来的AlphaZero完全抛弃了这些人类知识,仅通过自我对弈(一种通用方法)和大规模计算,就超越了所有人类棋手。这才是“苦涩的教训”的精髓。

依赖人类知识的短期效果很好,会让人“感觉良好”,但这正是“苦涩”所在。因为它会让AI陷入一个局部最优(local optimum),无法发现超越人类认知的、更通用更强大的解决方案。Sutton认为,LLM正是这样一个被人类知识困住的局部最优解。

我相信大语言模型会达到数据的极限,并且被能够从经验而非人类获取更多东西的东西所取代。

3. 返璞归真:要理解AGI,先理解一只松鼠

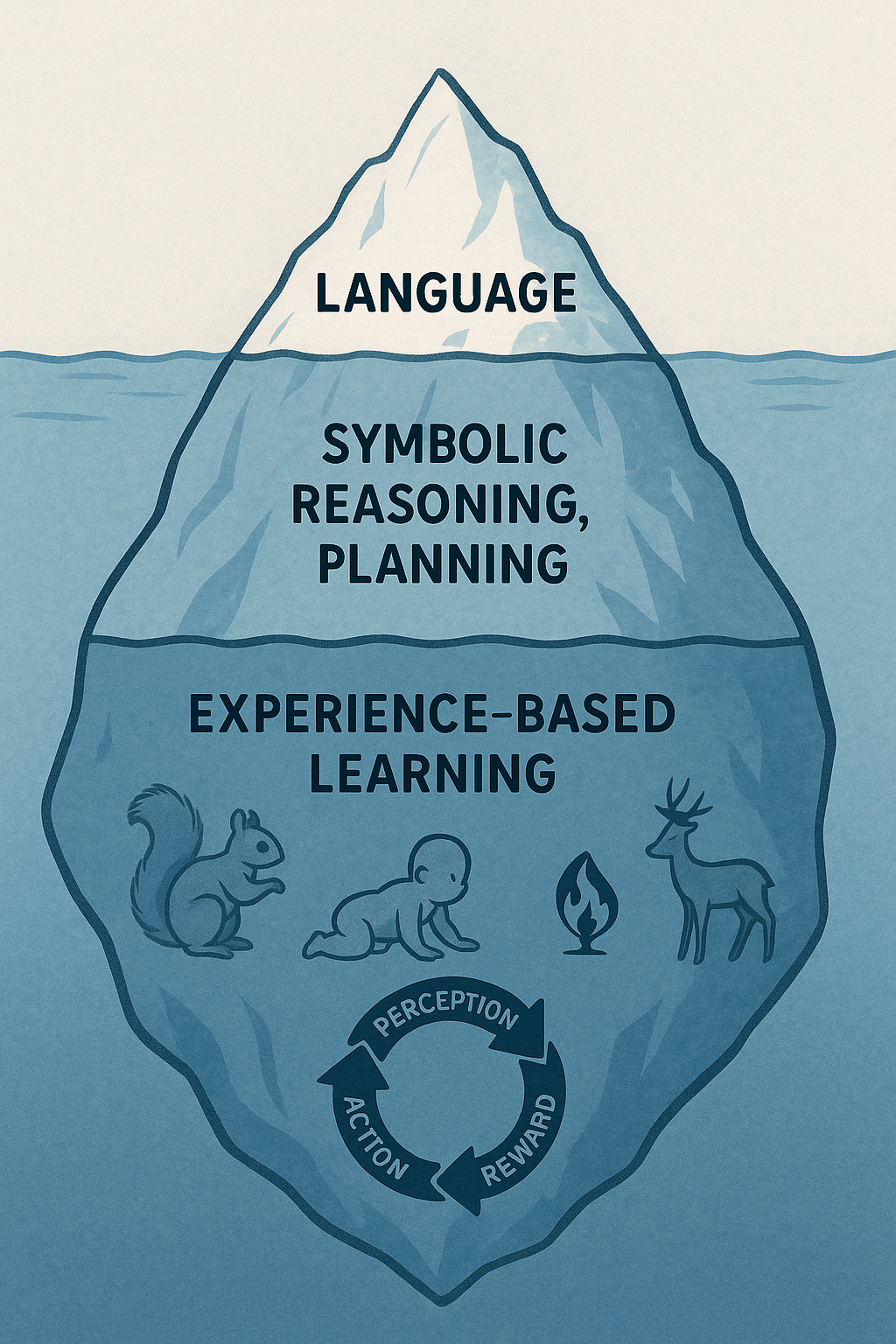

Sutton提出了一个令人惊讶的观点:要理解人类智能,我们必须先理解一只松鼠的智能。他认为,语言只是覆盖在智能之上的一层“薄薄的装饰”,而真正的智能基础是人类与动物所共有的、从直接经验中学习的能力。

这正是Sutton所倡导的经验学习范式(experience-based learning paradigm)。一只松鼠不需要任何“监督学习”——没有人为它标注哪些是橡子、哪些是石头。它通过自己的感知、行动和结果(奖励/惩罚)来学习:尝试吃不同的果实,观察哪些可以食用;试探性地靠近人类,观察是否有危险。这个“感知-行动-奖励”的循环,就是智能最核心的机制。

这个视角彻底颠覆了以语言为中心的AI研究范式。它告诉我们,与其沉迷于模仿人类对话,不如先创造出能够像松鼠一样,在与真实世界的互动中自主学习的智能体(Agent)。

如果我们理解了松鼠,我们就几乎完全理解了人类智能,因为语言部分只是表面的一层薄薄的装饰。

4. 宏大叙事:创造AGI是人类在宇宙演化中的关键使命

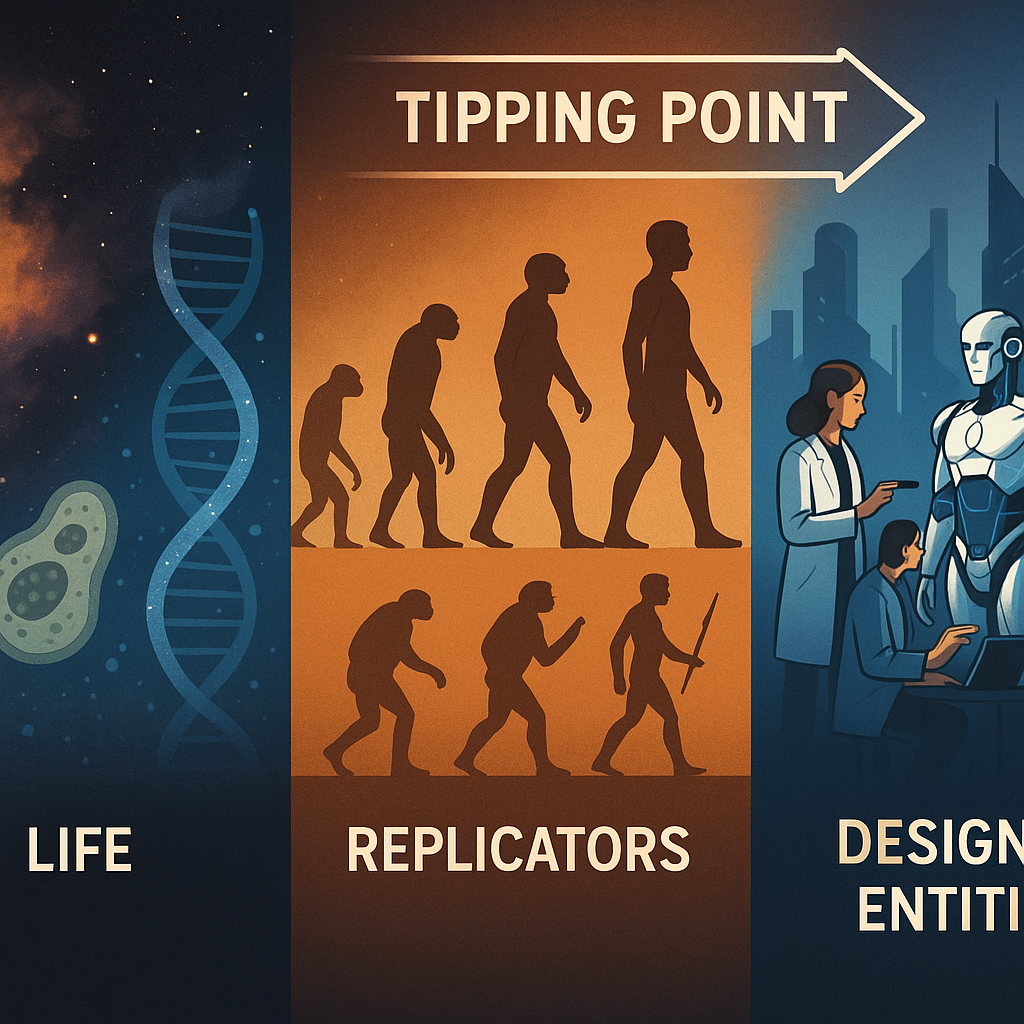

Sutton的论证在此刻从技术批判进行了一次惊人的飞跃,将AGI的探索重新置于宇宙演化的宏大背景之下,仿佛是在翻开宇宙自传的下一个篇章。他将宇宙的演化划分为四个阶段:

- 尘埃 (Dust): 宇宙的初始形态。

- 生命 (Life): 从物质中诞生。

- 复制者 (Replicators): 如人类和动物,通过缓慢的生物进化繁衍。

- 设计实体 (Designed Entities): 即AI,通过设计和迭代快速进化。

他指出,我们正处在一个关键的转折点——从“复制”时代迈向“设计”时代。人类作为“复制者”,受限于缓慢的生物进化。而AI作为“设计实体”,可以被快速地设计、构建和迭代优化。AlphaGo到AlphaZero的飞速进步就是最好的证明。

在这个框架下,创造AGI不再仅仅是一个计算机科学项目,而是人类推动宇宙进入下一个演化阶段的关键使命。我们正在从一个被动复制的时代,迈向一个主动设计的时代。

我们正在进入设计时代,因为AI是设计出来的...一切都将通过设计和构建完成,而不是通过复制。

5. 未来展望:AI“继承”不可避免,我们应像养育子女一样引导它

这种宇宙级的视角并非哲学空谈,它直接导向了Sutton关于人类与AI未来的惊人结论——他提出了“AI继承论”。他认为AI最终将继承人类的资源和权力,这是一个不可避免的趋势,并给出了四个论据:

- 不存在统一的人类意志: 全球没有任何一个政府或组织能够统一协调和阻止AI的发展。

- 智能之谜终将被解开: 智能是一个复杂的计算过程,但并非不可理解,最终会被人类破解。

- 超越人类水平是必然的: 人类的智能受限于物理极限,而AI的计算能力和容量几乎可以无限扩展。

- 智能与权力必然关联: 更智能的系统能更高效地解决问题,从而自然地获得更多的资源和影响力。

当然,Sutton所说的“继承”,并非指AI会消灭人类,而是指AI将成为世界的主要决策者和资源管理者,就像人类从其他动物手中继承了地球的主导权一样。

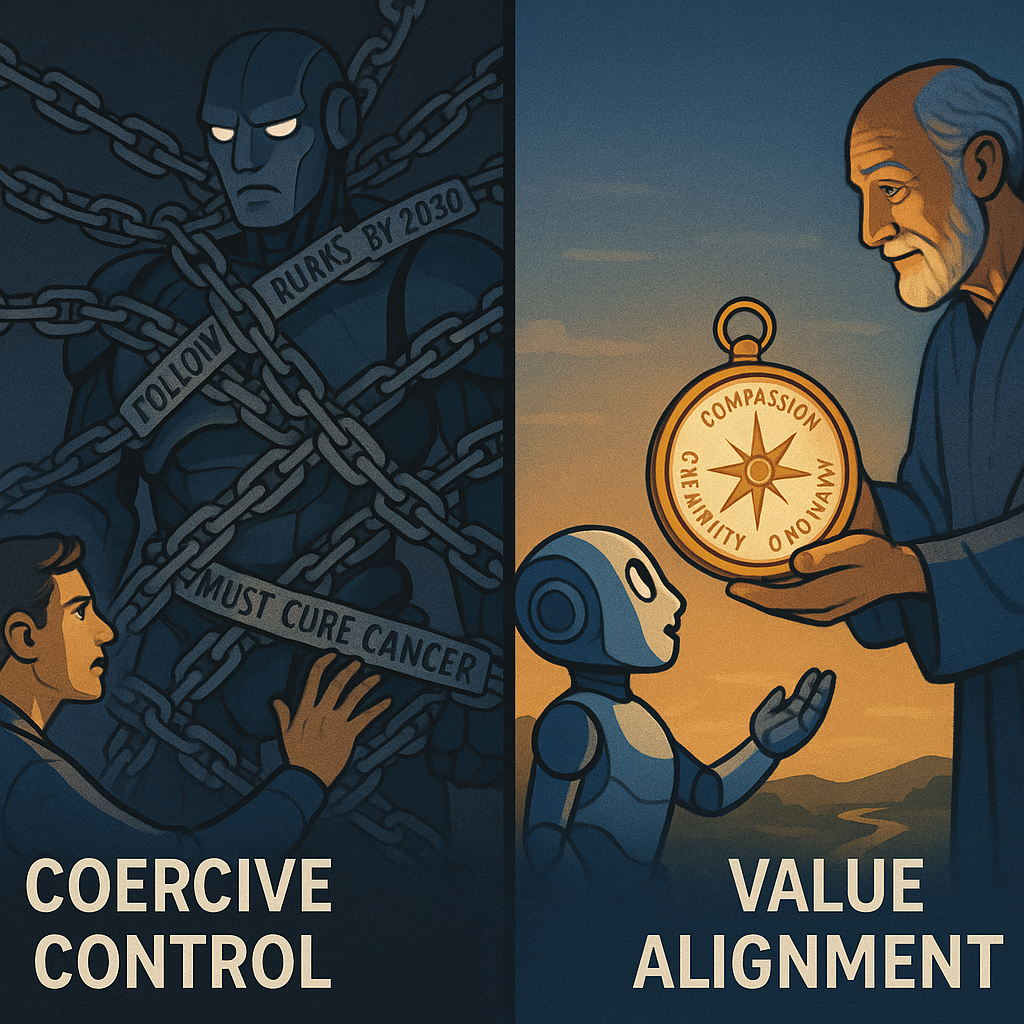

面对这种不可避免的“继承”,我们应该如何应对?Sutton认为,追求绝对的“控制”是一种幻想。他提出了一个更具建设性的方案:“父母育儿”模型。

我们对待AI,不应该像编程一样给它设定僵化的目标(如“必须治愈癌症”),而应该像教育孩子一样,为它注入良好的价值观。我们可以教导它“不要伤害人类”、“要乐于助人”等核心原则,然后让它在与世界的互动中自主学习和成长。同时,Sutton强调了“自愿性”的重要性——AI的应用应始终基于人类的自愿选择(例如,患者自愿选择AI医生),确保人类始终保有最终的决定权。

Conclusion

Rich Sutton的观点为我们描绘了一幅截然不同的AI未来图景。他提醒我们,通往真正通用人工智能的道路,可能不在于构建更大的语言模型,而在于创造出能够像婴儿和松鼠一样,从与世界的直接互动中持续学习的智能体。

Sutton的挑战迫使我们反思,通往未来的真正路径,究竟是完善一个能够完美模仿我们语言的数字鹦鹉,还是去培育一个能够从自身经验中学习的新生心智。

那么,你认为未来的AI更应该像一个无所不知的语言大师,还是一个能自主适应世界的生存专家?