type

Post

status

Published

date

Sep 18, 2025

slug

ai12

summary

Deep Learning 深度学习

tags

人工智能

category

人工智能

icon

password

Description

Deep Learning 深度学习

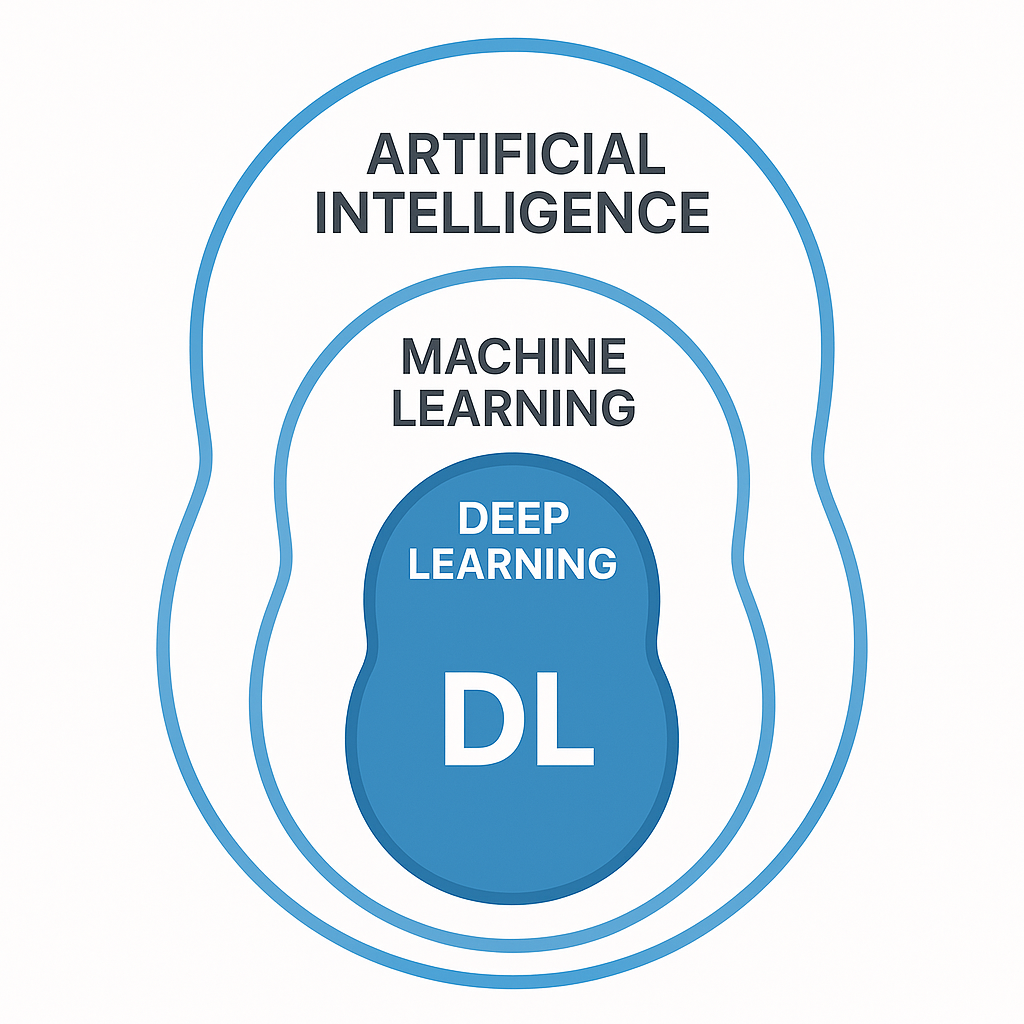

深度学习是机器学习的一个子领域,并且已经成为人工智能领域的一股强大力量。它使用具有多层(因此称为 “深度”)的人工神经网络来分析数据并学习复杂的模式。这些网络受到人脑结构和功能的启发,能够在各种任务中实现出色的性能。

深度学习可视为机器学习的一个专门子集。传统的机器学习算法通常需要人工特征工程,而深度学习算法可以自动从原始数据中学习相关特征。这种学习数据分层表示的能力使深度学习与众不同,并使其能够解决更复杂的问题。

在人工智能的大背景下,深度学习在实现创建智能代理和解决复杂问题的目标方面发挥着至关重要的作用。目前,深度学习模型已被用于各种人工智能应用中,包括自然语言处理、计算机视觉、机器人等。

深度学习背后的动机

深度学习背后有两个主要目标:

- 解决复杂问题: 事实证明,深度学习在解决以往传统人工智能方法无法解决的复杂问题方面非常有效。其从海量数据中学习复杂模式的能力已在图像识别、语音处理和自然语言理解方面取得了突破性进展。

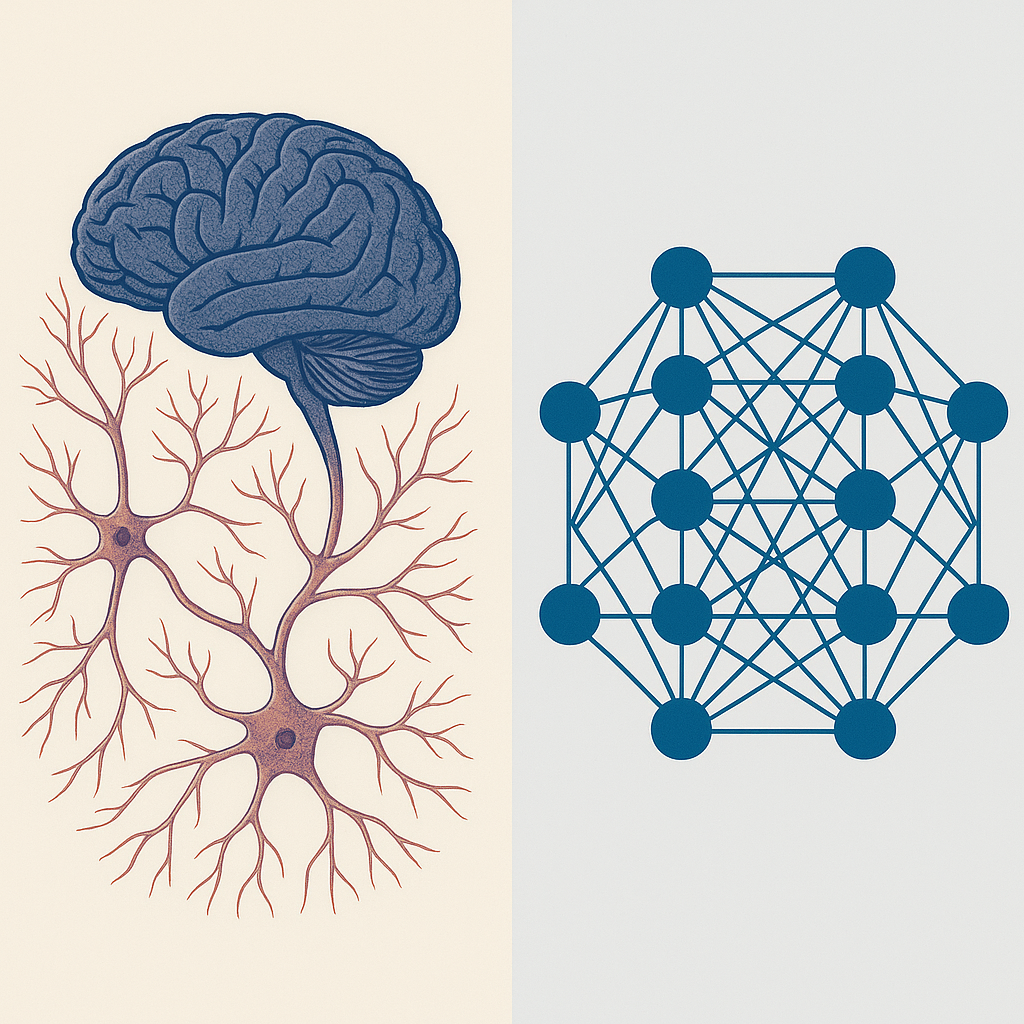

模仿人脑: 深度神经网络的架构灵感来源于人脑中神经元的互连网络。这使得深度学习模型能够分层处理信息,类似于人类感知和理解世界的方式。深度学习旨在通过模仿人脑来创建能更有效地学习和推理的人工智能系统。

深度学习已经成为一种变革性技术,可以彻底改变各个领域。它能够解决复杂问题并模仿人脑,因此成为人工智能进步的关键驱动力。

深度学习的重要概念

要理解深度学习,就必须掌握支撑其结构和功能的一些关键概念。

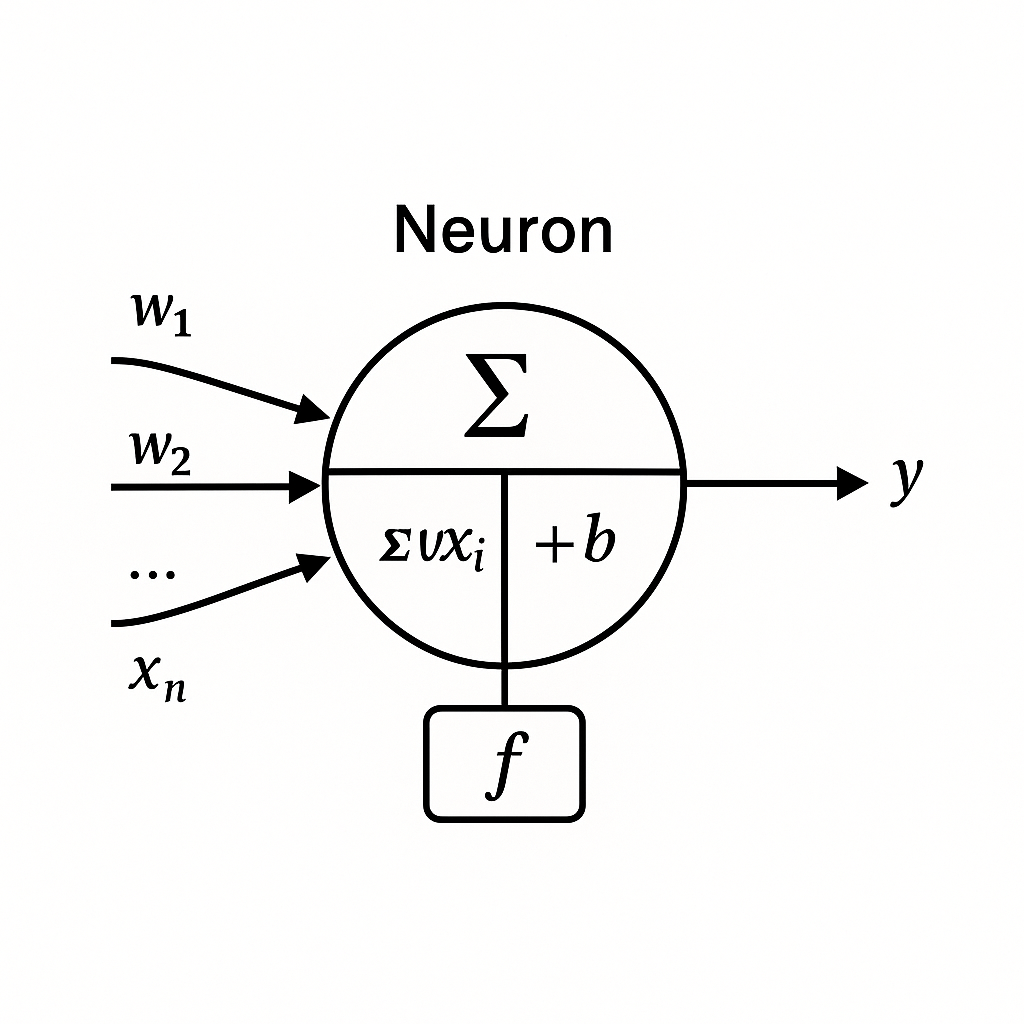

人工神经网络(ANNs)

人工神经网络 (ANNs)是受构成动物大脑的生物神经网络启发而产生的计算系统。人工神经网络由按层组织的相互连接的节点或 神经元 组成。神经元之间的每个连接都有一个 权重 ,代表连接的强度。

网络通过根据输入数据调整这些权重进行学习,从而做出预测或决策。ANN 是深度学习的基础,因为它们为构建可从海量数据中学习的复杂模型提供了框架。

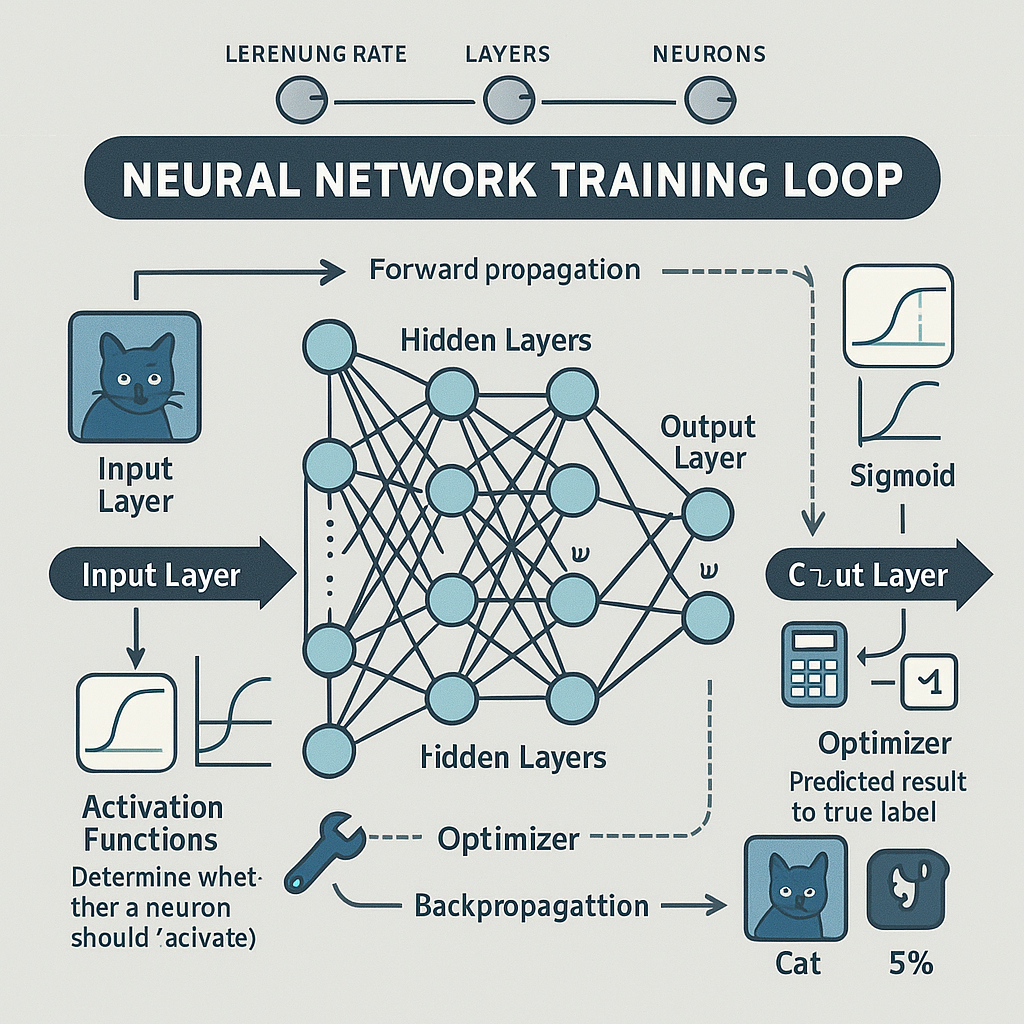

层数 (Layers)

深度学习网络的特点是分层结构。主要有三种类型的层:

- 输入层: 该层接收初始数据输入。

- 隐藏层: 这些中间层执行计算并从数据中提取特征。深度学习网络有多个隐藏层,可以学习复杂的模式。

- 输出层: 该层产生网络的最终输出,如预测或分类。

激活函数(Activation Functions)

激活函数将非线性引入网络,使其能够学习复杂的模式。激活函数根据神经元的输入决定是否激活该神经元。常见的激活函数包括:

- Sigmoid S-曲线函数: 将输入压缩到 0 和 1 之间的范围。

- ReLU(整流线性单元): 负输入时返回 0,正输入时返回输入值。

- Tanh(双曲正切): 将输入压缩到 -1 和 1 之间的范围。

反向传播 (Backpropagation)

反向传播是一种用于训练深度学习网络的关键算法。它包括计算有关网络权重的损失函数的梯度,然后按照损失最小化的方向更新权重。这种迭代过程允许网络从数据中学习,并随着时间的推移提高其性能。

损失函数 (Loss Function)

损失函数测量网络预测值与实际目标值之间的误差。训练的目标就是最小化这个损失函数。不同的任务需要不同的损失函数。例如, 均方误差通常用于回归任务,而交叉熵损失则用于分类任务。

优化器 (Optimizer )

优化器决定了网络权重在训练过程中的更新方式。它使用反向传播计算出的梯度来调整权重,使损失函数最小化。常用的优化器包括:

- Stochastic Gradient Descent 随机梯度下降算法 (SGD)

- Adam

- RMSprop

超参数 (Hyperparameters )

超参数在训练开始前设置,用于控制学习过程。例如学习率、隐藏层数和每层神经元数。调整超参数对实现最佳性能非常重要。

这些概念构成了深度学习的基石。要理解深度学习模型是如何构建、训练和用于解决复杂问题的,理解它们非常重要。

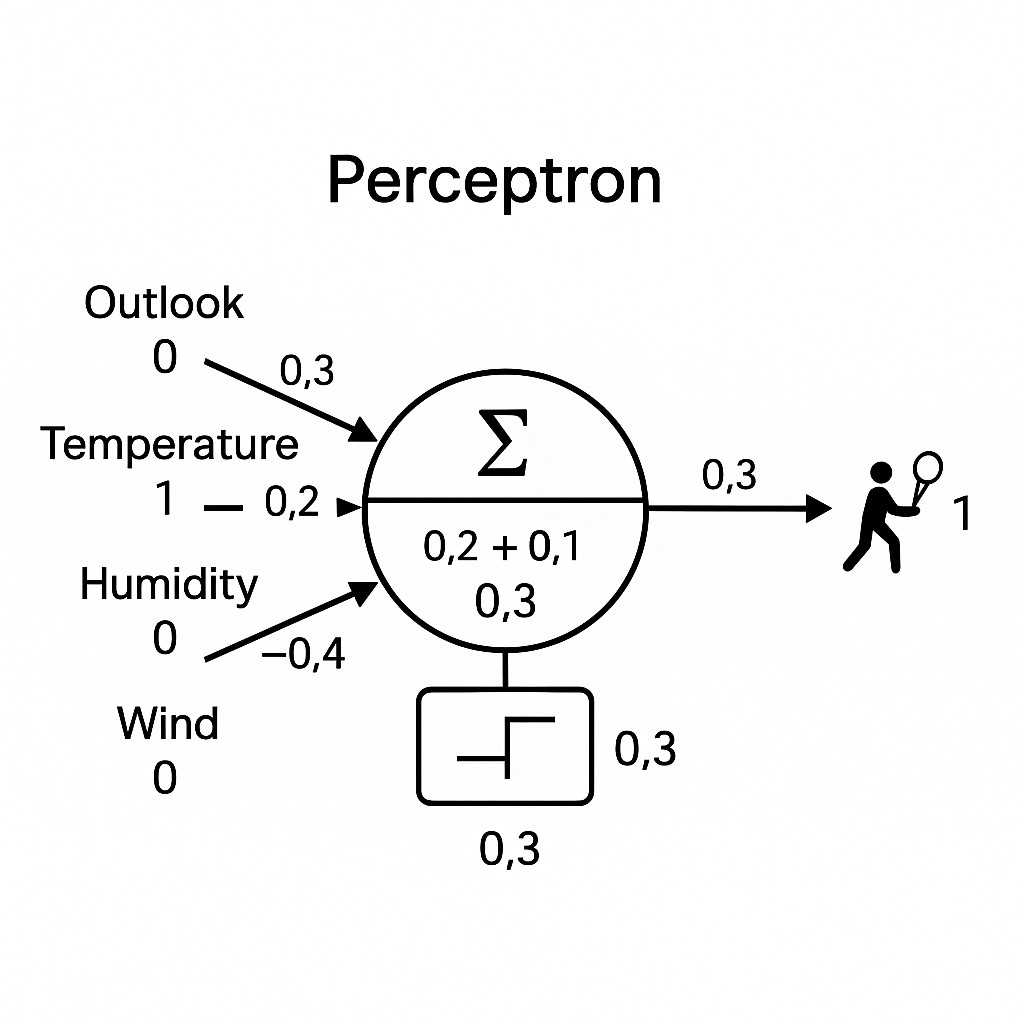

感知器

感知器(英文 Perceptrons)是神经网络的基本构件。它是生物神经元的简化模型,可以做出基本决策。了解感知器对于掌握深度学习中使用的更复杂神经网络背后的概念至关重要。感知器的结构

感知器由以下部分组成:

- Input Values (x1, x2, ..., xn): 这些是输入感知器的初始数据点。每个输入值代表数据的一个特征或属性。

- Weights(w1, w2, ..., wn): 每个输入值都与一个权重相关联,决定其强度或重要性。权重可正可负,影响感知器的输出。

- Summation Function (∑): 加权输入求和为 ∑(wi * xi)。这一步将加权输入值汇总为一个值。

- Bias (b): 偏置项被添加到加权和中,以移动激活函数。它允许感知器在所有输入为零时也能激活。

- Activation Function (f): 激活函数将非线性引入感知器。它将加权和加上偏置作为输入,并根据预定义的阈值产生输出。

- Output (y):感知器的最终输出,通常是一个二进制值(0 或 1),代表决策或分类。

总结

从本质上讲,感知器接收一组输入,乘以相应的权重,求和,添加偏置,然后应用激活函数产生输出。这种简单而强大的结构构成了深度学习中使用的更复杂神经网络的基础。

举例:是否去打网球

让我们用一个简单的例子来说明感知器的功能:根据天气情况决定是否打网球。我们将考虑四个输入特征:

- Outlook: Sunny (0), Overcast (1), Rainy (2)

- Temperature: Hot (0), Mild (1), Cool (2)

- Humidity: High (0), Normal (1)

- Wind: Weak (0), Strong (1)

我们的感知器将接收这些输入,并输出二进制决策:Play Tennis (1)或 Don't Play Tennis (0)。

为简单起见,我们假设权重和偏差如下:

- w1 (Outlook) = 0.3

- w2 (Temperature) = 0.2

- w3 (Humidity) = -0.4

- w4 (Wind) = -0.2

- b (Bias) = 0.1

使用一个简单的阶跃激活函数:

现在,让我们考虑一天的情况:

- Outlook: Sunny (0)

- Temperature: Mild (1)

- Humidity: High (0)

- Wind: Weak (0)

感知器计算加权和:

增加偏差:

应用激活函数

输出为 1,因此感知器决定打网球 。

在 Python 中,看起来像这样:

这个基本例子演示了感知器如何权衡不同的输入,并根据简单的激活函数做出二元决策。在现实世界中,感知器通常被组合成复杂的网络,以解决更复杂的任务。

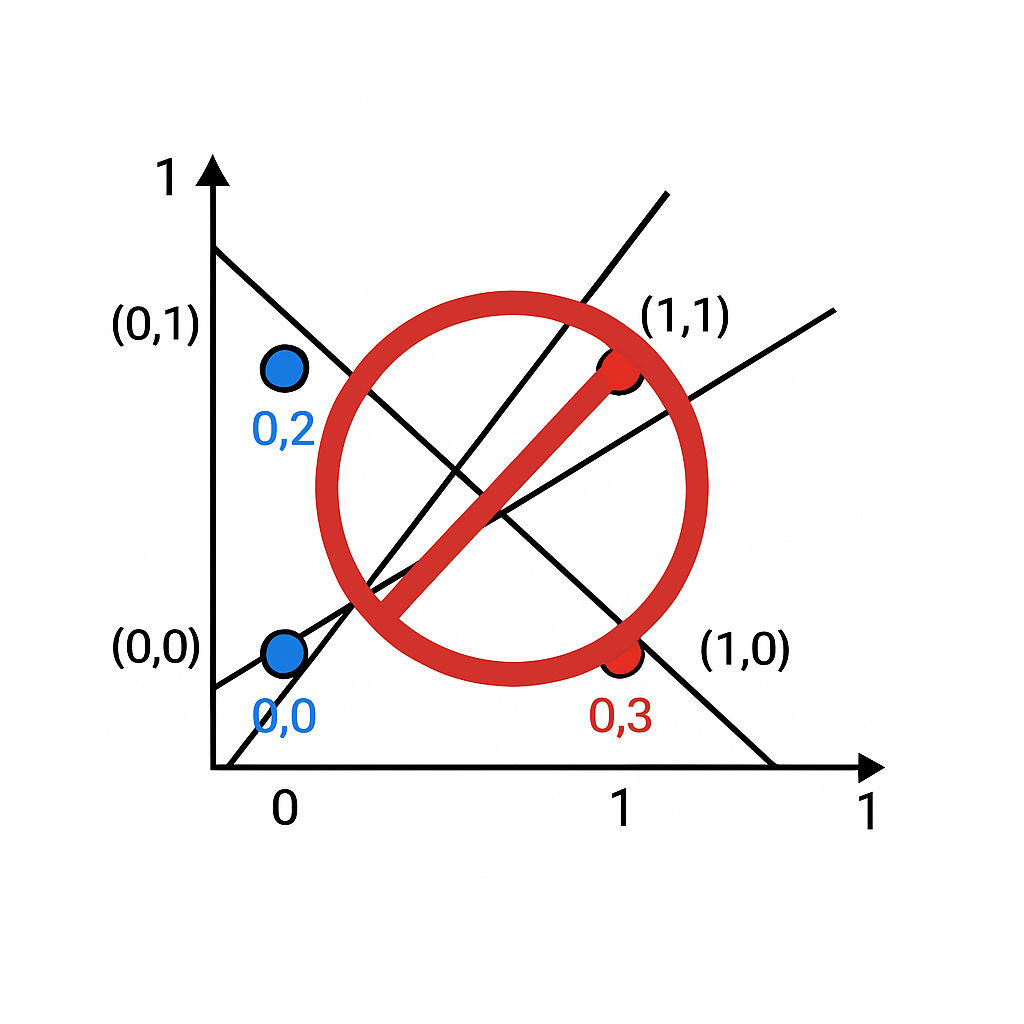

感知器的局限性

虽然感知器提供了对神经网络的基础理解,但单层感知器有很大的局限性,限制了其对更复杂任务的适用性。

最明显的局限是无法解决非线性可分的问题。如果一个数据集能被一条直线(或高维度的超平面)分为两个类别,则该数据集被认为是线性可分的。单层感知器只能学习线性决策边界,因此无法对非线性模式的数据进行分类。

一个典型的例子就是 XOR 问题。如果只有一个输入为真,则 XOR 函数返回真值(1),否则返回假值(0)。不可能画出一条直线来分隔 XOR 函数的真假输出。这一限制严重制约了单层感知器所能解决的问题类型。